[이슈밸리=임정은 기자] 삼성전자가 28일(현지 시각) 미국 캘리포니아주 마운틴뷰에서 열린 반도체 학술행사인 'MemCon 2023'에서 최신 메모리 솔루션을 대거 선보였다고 밝혔다.

MemCon 2023은 인공지능(AI) 관련 메모리 솔루션을 심층적으로 다루기 위해 올해 처음 열린 학회로 삼성전자를 포함해 구글, 마이크로소프트 등 글로벌 IT기업이 참가했다.

이번 학회에서 삼성전자 미주법인 메모리연구소장 최진혁 부사장은 '데이터 중심 컴퓨팅 시대의 메모리 혁신'을 주제로 기조연설을 했다.

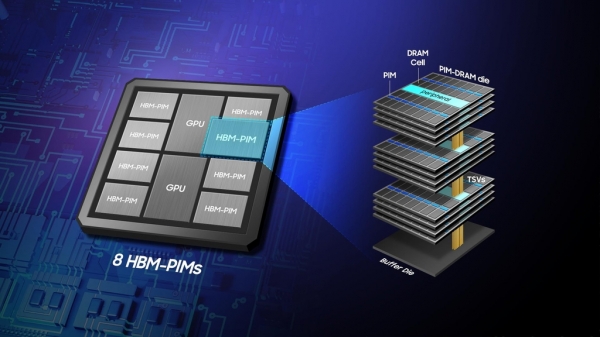

최 부사장은 고성능 메모리에 연산 기능을 내장한 'HBM-PIM', 연산 기능을 메모리 옆에 위치시킨 'PNM', 시스템의 메모리 용량을 테라바이트급까지 확장할 수 있는 'CXL D램' 등을 소개했다.

또 솔리드 스테이트 드라이브(SSD) 내부 연산 기능을 강화한 '2세대 스마트SSD', 서버 시스템의 공간 활용도를 높인 '페타바이트 스토리지', AI·머신러닝에 최적화된 '메모리 시맨틱 SSD' 등 차세대 메모리 기술을 제시했다.

자율주행과 휴먼 로봇, 음성인식, 메타버스 등 다양한 미래 기술의 융합으로 AI 반도체 시장은 급성장하고 있다.

시장조사업체 가트너에 따르면 지난해 AI 반도체 시장 규모는 전년보다 27.8% 증가한 444억달러로 집계됐다. 2026년에는 861억달러에 이를 것으로 전망된다.

또 AI를 활용한 대화형 챗봇인 챗GPT의 활성화에 따라 폭증하는 데이터를 처리하기 위한 차세대 메모리 기술이 주목받고 있다.

특히 HBM PIM과 CXL 기반 PNM을 활용하면 AI의 성능과 효율 측면에서 상당한 개선 효과를 거둘 수 있을 것으로 기대된다.

챗GPT와 같은 대규모 모델의 경우, 메모리 병목 현상으로 문장 생성 속도가 지연되기도 한다.

이를 극복하기 위해 해당 모델에 HBM-PIM 기술을 적용할 경우 기존 HBM이 탑재된 GPU 가속기에 비해 AI 모델의 생성 성능이 약 3.4배 개선될 것으로 전망된다.

또 CXL 기반 PNM 기술 적용 시 기존 GPU 가속기 대비 D램 용량은 4배 증가하고 AI 모델의 로딩 속도는 2배 이상 빨라진다고 삼성전자는 설명했다.

삼성전자 관계자는 "메모리 산업의 지속적 발전을 위해 다양한 차세대 메모리 솔루션을 개발하고 글로벌 IT기업과 협력을 강화해 메모리 패러다임 변화를 주도해 나갈 것"이라고 말했다.